AKTUELLE NEWS AUS DER KI-WELT

EIN LEHRER LÄSST KI BEI KLASSENARBEITEN ZU

KI-Tools halten Einzug ins Klassenzimmer: Auch in Schulen generieren Schüler mittlerweile auf Knopfdruck Texte, Präsentationen, Bilder und Übersetzungen. Wie können Lehrkräfte mit den neuen Möglichkeiten von KI umgehen?

Für viele Lehrkräfte stellt sich die Frage nach der Selbstständigkeit von Hausaufgaben, Präsentationen und – besonders sensibel – von Prüfungsleistungen. Wie sollen sie Klassenarbeiten und Klausuren bewerten, wenn nicht eindeutig gesichert ist, von wem die Prüfungsleistung stammt – Prüfling oder KI?

Ein gängiger Reflex auf digitale Entwicklungen im Bildungswesen ist, diese Möglichkeiten zu reglementieren, digitale Endgeräte in Prüfungsmodi ohne Netzzugriff zu versetzen, oder KI-Tools zu verbieten.

Das Evangelisch Stiftische Gymnasium (Gütersloh) geht den gegenteiligen Weg: Seit 20 Jahren sind dort Laptops und iPads im flächendeckenden Einsatz. GPT-3 und Co. werden im Deutschunterricht praktisch erprobt und sind sogar bei der Klassenarbeit erwünscht.

Die Schule experimentiert seit Beginn der Pandemie mit zeitgemäßeren und digitalen Prüfungsformaten, die stärker an der späteren Lebenswirklichkeit orientiert sind. Zu dieser neuen Prüfungskultur zählt auch die KI-Klassenarbeit: Schüler können ihre Arbeit komplett oder in Teilen mit Unterstützung durch eine Text-KI schreiben.

Doch widerspricht der Einsatz von KI-Tools nicht dem Kerngedanken von Prüfungen: dass Schüler Leistungen eigenständig erbringen müssen?

Nicht unbedingt. Es gibt bei der KI-Klassenarbeit eine Vorgabe, die das verhindert: Übernommene Teile – wie bei Zitaten üblich – werden als fremde Textteile kenntlich gemacht. Die Schüler müssen am Ende in einem Reflexionsteil begründen, warum sie bestimmte Teile ihrer Klassenarbeit von der KI übernommen oder auch bewusst selbst verfasst haben.

Klassenarbeit mit KI: Schüler und Schülerinnen lernen Eigenverantwortung

Die Klasse 8a sitzt am Prüfungstag gespannt im Klassenraum. Die Schüler werden schriftliche Argumentationen verfassen, natürlich am Laptop – kein Prüfungsmodus, keine Einschränkungen beim Netzzugang, freier Zugang zu KI-Tools.

Sie tippen die Argumentationsthemen in die Eingabemaske der Schreib-KI ein. Nach wenigen Sekunden liegt der fertige Argumentationstext vor.

Wer meint, die Jugendlichen könnten sich jetzt zurücklehnen, irrt. Die Arbeit fängt für die Prüflinge erst richtig an: Sie müssen den KI-Text kritisch unter die Lupe nehmen.

Im Unterricht hatten die Schüler zuvor gelernt, dass es unklug ist, KI erzeugte Texte einfach zu übernehmen: So richteten sie zum Beispiel in der Woche vor der Klassenarbeit die Frage an die KI, ob die Nutzung von Smartphones in Schulen erlaubt sein solle. Die meisten KI-Texte sprachen sich für ein Smartphone-Verbot aus und priesen die Vorzüge eines rein analogen Unterrichts mit zum Teil wirren Argumenten ohne Belege an, etwa, dass Schüler in der Schule zu viele SMS schreiben.

Vier Probleme bei der KI-Klassenarbeit und wie Schülerinnen mit ihnen umgehen

- KI-Texte reproduzieren teilweise gesellschaftliche Stereotypen und konservative Sichtweisen.

- Text-KIs greifen auf veraltete Informationen zurück – GPT-3 etwa ist auf dem Trainingsstand von 2019.

- Grammatikalisch und stilistisch sind viele KI-Texte in deutscher Sprache stark verbesserungswürdig.

- Arbeitsaufträge werden von der KI oft nur unzureichend erfüllt oder die KI weicht vom Thema ab, liefert bei Argumenten zu selten Belege.

Dass bei KI-Texten noch Luft nach oben ist, zeigt ein Sprachwechsel: Englischsprachige KI-Texte sind deutlich aktueller, elaborierter und konsistenter.

Dies regte die Schüler dazu an, mehrere KI-Tools zu kombinieren: Sie starteten mit einer englischsprachigen Anfrage für englische Texte. Die Übersetzung in ihre Muttersprache erfolgte dann mit einem KI-Übersetzungstool (deepl.com). Danach fand eine stilistische und grammatikalische Überarbeitung mit LanguageTool oder Papyrus Autor statt.

Quelle: Hendrik Haverkamp, the decoder

DIE BESTEN DEUTSCHEN KI-FORSCHER

Seit über drei Jahrzehnten mischen deutsche Forscherinnen und Forscher auf dem Feld der Künstlichen Intelligenz mit. Durch ihr Engagement bringen sie die technologische Entwicklung von KI voran und beeinflussen den öffentlichen Diskurs, entscheiden über Fördermaßnahmen und über die Ausrichtung des Forschungsfelds. Einige der bekanntesten Köpfe stellen wir hier vor.

Ob in Forschung, Politik, Öffentlichkeit oder Wirtschaft: Künstliche Intelligenz ist in Deutschland überall Thema, insbesondere mit Blick auf den technologischen Fortschritt und globalen Wettbewerb. Aus politischer und gesellschaftlicher Sicht ist KI von wesentlicher Bedeutung.

Institutionell verankert wurde der Begriff Künstliche Intelligenz erstmals im Jahr 1988 mit der Gründung des Deutschen Forschungszentrums für Künstliche Intelligenz (DFKI). Mit der Pionier-Institution startete die KI-Forschung in der BRD mit ersten Standorten in Kaiserslautern und Saarbrücken.

Das DFKI ist auch noch heute eine wichtige deutsche KI-Institution. Mit dem KI-Boom der letzten Jahre haben sich jedoch in der gesamten Bundesrepublik viele Akteur:innen in Forschungs- und Wirtschaftsinstitutionen etabliert. Die wichtigsten Stakeholder unter ihnen bestimmen maßgeblich den Diskurs auf dem Gebiet.

Forschungsministerium unterstützt DFKI

Um die Sichtbarkeit und Wettbewerbsfähigkeit der Bundesrepublik bezüglich KI auf dem globalen Parkett zu stärken, rief die Bundesregierung im Jahr 2018 die Nationale Strategie Künstliche Intelligenz (kurz: KI-Strategie) aus.

Mit fünf Milliarden Euro werden bis zum Jahr 2025 KI-Forschungsvorhaben, -Projekte und innovative Entwicklungen gefördert. Ziel ist es, den meist Richtung Silicon Valley gerichteten Blick verstärkt auf eine „AI made in Germany“ zu lenken. Die Strategie fördert gezielt Hochschulen und Kompetenzzentren sowie einzelne Forschungsvorhaben.

Der Großteil der Fördermittel fließt über das Bundesministerium für Bildung und Forschung (BMBF) ab, dem seit 2021 Volkswirtin Bettina Stark-Watzinger (FDP) als Ministerin vorsteht. Ihr Ministerium unterstützt etwa das oben genannte DFKI als Projektförderer mit mehreren Millionen Euro pro Jahr. Mittlerweile betreibt das DFKI Standorte in mehreren deutschen Städten mit über 1.100 Beschäftigten und arbeitet in zahlreichen Gremien eng mit Politik und Wirtschaft zusammen.

Einer der Gründungsdirektoren des DFKI ist Wolfgang Wahlster, der von 1997 bis Anfang 2019 auch die Leitung des Instituts innehatte. Wahlster war 36 Jahre lang Informatikprofessor an der Universität des Saarlandes, unter anderem mit dem Schwerpunkt Kognitive Assistenzsysteme.

Heute ist er einer der bekanntesten KI-Forscher:innen der Bundesrepublik. Träger zahlreicher Preise und Ehrendoktorwürden, darunter der „Deutsche Zukunftspreis“ im Jahr 2001, zählt Wahlster mittlerweile sogar zu den bedeutendsten Intellektuellen Deutschlands. Ihm zufolge könnte sich „AI made in Germany“ zum Exportschlager entwickeln.

Aktueller Leiter des DFKI ist Antonio Krüger, ebenfalls Informatiker der Universität des Saarlandes mit dem Fokus Kognitive Assistenzsysteme. Krüger wurde 2018 von der CDU-CSU-Fraktion als Sachverständiger in die Enquete-Kommission „Künstliche Intelligenz – Gesellschaftliche Verantwortung und wirtschaftliche, soziale und ökologische Potenziale“ des Deutschen Bundestags berufen. Die Kommission befasste sich zwei Jahre lang in unterschiedlichen Projektgruppen mit den Auswirkungen des zunehmenden Einsatzes von KI.

Bekannte deutsche KI-Forscher und -Forscherinnen

Ein weiteres Sachverständigen-Mitglied der Enquete-Kommission ist Katharina Zweig. Die studierte Biochemikerin und Bioinformatikerin leitet aktuell das Algorithm Accountability Lab am Fachbereich Informatik der TU Kaiserslautern.

Als Universitätsprofessorin liegt ihr Schwerpunkt auf den Auswirkungen von Algorithmen auf Individuum, Organisation und Gesellschaft sowie der Kommunikation darüber. 2016 war sie Mitgründerin der Plattform AlgorithmWatch, wofür sie zwei Jahre später mit der Theodor-Heuss-Medaille ausgezeichnet wurde. Außerdem bekam sie 2019 den Communicator-Preis der Deutschen Forschungsgemeinschaft (DFG) und des Stifterverbands für herausragende Wissenschaftskommunikation.

Zu den im Wissenschaftsjahr 2019 von der Gesellschaft für Informatik e. V. (GI) gekürten zehn prägenden Köpfen der deutschen KI-Forschung zählt auch Elisabeth André. Als Inhaberin des Lehrstuhls Menschzentrierte Künstliche Intelligenz an der Universität Augsburg erforscht die Informatikerin neue technische Methoden der Mensch-Maschine-Interaktion und wie sich diese vereinfachen lassen. André erhielt zahlreiche weitere Auszeichnungen, darunter den Gottfried Wilhelm Leibniz-Preis im Jahr 2021. Sie ist Mitglied der Academia Leopoldina und der Bayerischen Akademie der Wissenschaften.

Wie auch Elisabeth André wurde der Informatiker Bernhard Schölkopf 2019 zu den prägenden Köpfen der KI-Forschung in Deutschland gekürt. Schölkopf ist ebenfalls Mitglied der Leopoldina und seit 2011 Direktor des neu gegründeten Max-Planck-Instituts für Intelligente Systeme in Tübingen, wo er auch die Abteilung Empirische Inferenz leitet. Er ist Co-Initiator des Cyber Valley der Region Stuttgart-Tübingen, Europas größtem Forschungskonsortium im Bereich der Künstlichen Intelligenz. Hier kooperieren die Universitäten Tübingen und Stuttgart mit Großkonzernen wie Daimler, Porsche, Amazon und BMW sowie dem Max-Planck-Institut und dem Land Baden-Württemberg.

Kristian Kersting, Informatikprofessor für maschinelles Lernen an der TU Darmstadt, ist unter anderem bekannt für seine Forschung zu Statistischer Relationaler KI und Probabilistischem Deep Learning. Sein Fokus liegt auf Fragen der moralischen Handlungsfähigkeit von KI. Als Mitglied von ATHENE, Europas größtem Forschungsinstitut für IT-Sicherheit, ist Kerstings Forschungsinteresse stark europäisch orientiert.

2019 wurde er zum Fellow der European Association for Artificial Intelligence (EurAI) sowie des European Laboratory for Learning and Intelligent Systems (ELLIS) ernannt. Im selben Jahr erhielt er den mit 100.000 Euro dotierten „Deutschen KI-Preis“ für seine wissenschaftlichen Beiträge auf dem Bereich KI.

Kersting ist zudem Gründungsmitglied von hessian.AI, einem Forschungsverbund von 13 hessischen Hochschulen, das Grundlagenforschung leisten und zudem den Transfer in Wirtschaft und Gesellschaft vorantreiben soll. Mit Kristian Kersting sprachen wir im KI-Podcast DEEP MINDS über die dritte Welle Künstliche Intelligenz.

KI-Forschung soll in der Wirtschaft ankommen

Im Rahmen der KI-Strategie fördert die Bundesregierung bis 2025 innovative KI-Projekte mit konkretem Umsetzungscharakter: Kleinere und mittlere Unternehmen (KMU) sollen darin unterstützt werden, Künstliche Intelligenz in ihre Unternehmenspraxis zu integrieren. Dass die Strategie dabei bis in den deutschen Mittelstand reichen soll, zeigt bereits, für wie wichtig das Thema aus wirtschaftlicher Sicht im Zuge der angestrebten Digitalisierung erachtet wird.

Ein bedeutendes Netzwerk in diesem Zusammenhang ist die Plattform Lernende Systeme, die 2017 vom BMBF ins Leben gerufen wurde. Hier sind knapp 200 Expert:innen aus Wirtschaft, Wissenschaft und Gesellschaft in unterschiedlichen Arbeitsgruppen organisiert, um Positionen und Handlungsvorgaben für die ethische Anwendung von KI-Technologien zu erarbeiten. Dem Lenkungskreis der Plattform gehört unter anderem auch Wolfgang Wahlster an.

Eine bekannte Persönlichkeit mit Blick auf Wirtschaft und KI ist Tina Klüwer. Die promovierte Computerlinguistin ist Direktorin des Künstliche Intelligenz Entrepreneurship Zentrums – kurz K.I.E.Z. Das Zentrum mit Sitz in Berlin ist eine Initiative von Science & Startups, dem Verbund der Startup-Services der Berliner Universitäten und der Charité Universitätsmedizin. Das Zentrum fördert wissenschaftsnahe Unternehmensgründungen sowie deren Skalierung und Internationalisierung.

Im Juli dieses Jahres wurde Klüwer zudem durch Bundeskanzler Olaf Scholz als Mitglied des Zukunftsrats berufen. Das neue Gremium wurde für die Dauer der 20. Legislaturperiode eingesetzt und soll Vorschläge zur Stärkung des Forschungs- und Innovationssystems, der Resilienz und der technologischen Souveränität erarbeiten.

Quelle: Sarah Schmitt, the decoder

AI LEADERS- DER FONDS

Webinar

Die größte Transformation in der Geschichte der Menschheit

Die Entwicklung der Menschheit ist grenzenlos – so auch das Potenzial der künstlichen Intelligenz. Diese bietet weltweit die größten Wachstumsperspektiven, welche bereits internationale Investoren als Opportunität erkennen.

Das Ausmaß der Ausbreitung auf alle Branchen ist nicht zu unterschätzen. Unternehmen, die bereits in diesen Bereichen agieren, werden nachhaltige Wettbewerbsvorteile des größten Treibers für Innovation und Disruption genießen.

Christian Hintz, Fondsmanager von AI Leaders, ist überzeugt davon, dass Artificial Intelligence zukünftig den Markt anführt und das Potenzial bietet, die 4. industrielle Revolution auszulösen.

In unserem gemeinsamen Webinar stellt Christian Hintz einen Zugang zu Investitionsmöglichkeiten vor, die Künstliche Intelligenz aktiv vorantreiben.

Anmeldung: events@capinside

Datum: 25. 11. 2022

Uhrzeit: 10 Uhr

Wir freuen uns auf Ihre Teilnahme und auf einen spannenden Webcast mit regem Austausch.

AI LEADERS – DER FONDS

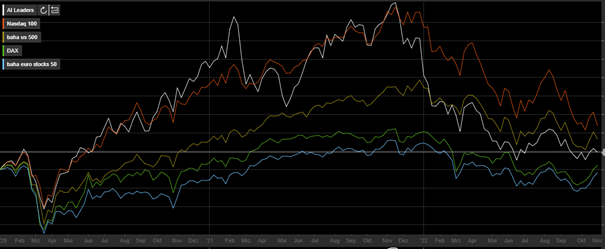

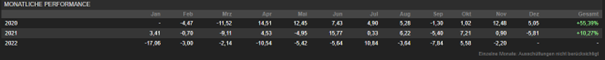

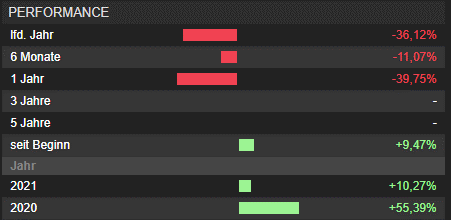

Der AI Leaders konnte sich der allgemeinen Entwicklung seit November 2021 nicht entziehen und gab einen großen Teil seiner Corona Gewinne wieder ab.

Inzwischen bewegt sich der Fonds im Bereich eines 18 er KGV, was im Vergleich zu den letzten Jahrzehnten als ungewöhnlich niedrig zu sehen ist.

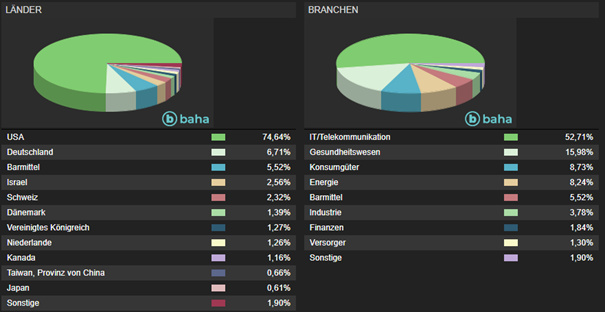

Die USA nimmt seit Beginn den größten Teil des Portfolios ein, was sich aus heutiger Sicht auch in den nächsten Jahren nicht ändern wird.

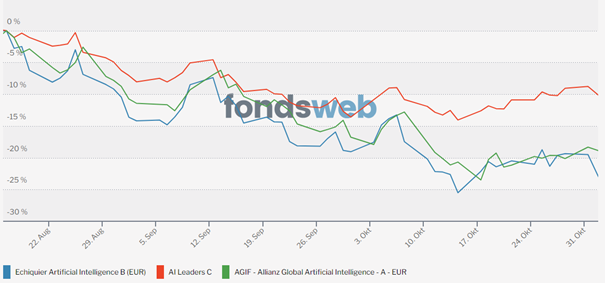

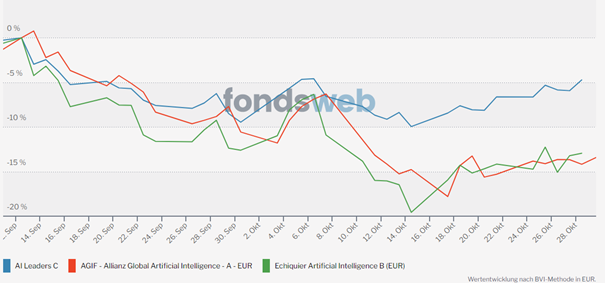

Durch den Einsatz von TOPAS hat sich seit Mitte September das Portfolio deutlich geändert, obwohl das Aktienuniversum von 161 Aktien unverändert blieb.

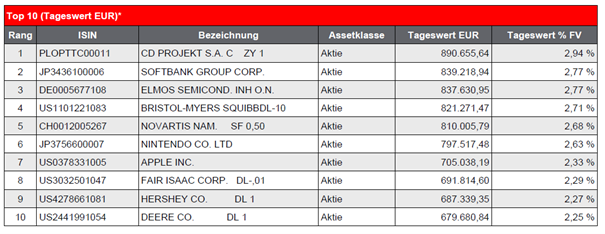

Schon seit April 2022 hebt sich der AI Leaders seinen größten Konkurrenten bzgl. der Volatilität positiv ab. Seit Mitte September werden diese Unterschiede aber deutlich sichtbar. Die Volatilität und der draw-down konnten deutlich reduziert werden.

Der AI Leaders bewegt sich seitdem mit den üblichen Marktschwankungen.

Wie die deutlichen Verbesserungen bei gleichbleibendem Aktienuniversum zu erklären sind, erläutert Prof. Dr. Patrick Peters in dem neulich erschienen Artikel, den wir auszugsweise hier veröffentlichen:

Portfolio-Risikomanagement bei Wachstumswerten

Growth Investing war über viele Jahre hinweg der Performancebringer für viele Portfolios. Zuletzt sind die Werte jedoch unter Druck geraten und weisen eine stark erhöhte Volatilität auf. Durch professionelles Portfolio-Risikomanagement mit dem „TOPAS“-Algorithmus des Risikomanagers ELAN Capital-Partners können die Faktorprämien von Wachstumswerten eingenommen werden, während die Volatilität auf einem gesamtmarktüblichen Niveau gehalten wird, erklärt Christian Hintz, Portfoliomanager des auf Künstliche Intelligenz spezialisierten Aktienfonds „AI Leaders“ (WKN: A2PF0M / ISIN: DE000A2PF0M4) (https://ai-leaders.de).

Die Erfolgsgeschichte des Growth Investing ist lang. Viele Technologiewerte – von A wie Apple bis T wie Tesla – waren seit Mitte der 10er-Jahre die absoluten Gewinner an den Börsen und haben vielen Menschen zu satten Gewinnen verholfen. Tesla beispielsweise hat in drei Jahren fast 1900 Prozent zugelegt, Apple immer noch mehr als 250 Prozent. Beim Streamingdienst Netflix waren es in den fünf Jahren vor der einschneidenden Korrekturphase ab Herbst 2021 deutlich mehr als 600 Prozent. Heute liegen viele dieser Werte auf Sicht von drei Jahren und zumeist auch fünf Jahren deutlich im Minus, und die Volatilität von Growth-Titeln ist ebenfalls deutlich gestiegen. Das führt dazu, dass Growth Investing für viele Investoren derzeit nicht die höchste Attraktivität besitzt – ein potenzieller Anlageerfolg muss teuer erkauft werden.

Das gilt auch für einen Spezialbereich wie die Künstliche Intelligenz. Sie ist der große Game Changer in Wirtschaft und Gesellschaft. Geschäftsmodelle und ganze Branchen werden sich durch die Künstliche Intelligenz verändern, und ohne die kontinuierliche Weiterentwicklung dieser Systeme können künftig die gigantischen Datenmengen gar nicht mehr organisiert und genutzt werden.

Auch bei zukunftsreichen Investments nicht die Volatilität aus dem Blick zu verlieren

Diese rasante Entwicklung lässt sich an den Marktdaten ablesen. Bis 2030 erwarten Experten für die Künstliche Intelligenz einen Wertschöpfungsbeitrag zum weltweiten Bruttosozialprodukt in Höhe von 1,2 Prozent pro Jahr. Das sind 13 Billionen US-Dollar und doppelt so viel wie bei den Dampfmaschinen der ersten industriellen Revolution und der allgemeinen Informations- und Kommunikationstechnologie.

Daher gilt die Künstliche Intelligenz als Beginn einer vierten industriellen Revolution und als die herausragende Disruption mit gigantischen Zukunftspotenzialen für Wirtschaft und Gesellschaft. Das führt gleichzeitig zu einer weitreichenden Umsatzsteigerung im Bereich von KI-Anwendungen. Diese betrug 2020 knapp 19 Milliarden US-Dollar und soll 2025 bei rund 90 Milliarden US-Dollar liegen.

Der Einstiegszeitpunkt ist also sehr gut. Aber es kommt eben auch bei so zukunftsreichen Investments darauf an, die Volatilität nicht aus dem Blick zu verlieren. Denn diese existiert zwangsläufig auch in allen Subsegmenten von Growth. Daher müssen die Chancen von Growth, auch mit dem Fokus auf die Künstliche Intelligenz als dem Wachstumsmarkt innerhalb von Growth schlechthin, mit echtem Portfolio-Risikomanagement kombiniert werden.

Aufgrund von wechselnden Marktphasen ist eine statische Asset Allokation selten optimal

Aber was bedeutet das konkret, die Risiken für die Anleger zu begrenzen und gerade in schwierigen Marktphasen die Anzahl und Höhe der Rücksetzer möglichst gering zu halten? Die Vermögensallokation ist entscheidend. Wie anerkannte wissenschaftliche Studien belegen, hängt die Wertentwicklung eines Portfolios wesentlich von der Allokation auf verschiedene Assetklassen ab. Anders gesagt: Auch eine begründete strategische Anlage kann zu ungünstigen Ergebnissen führen. Die strategische Asset Allokation allein garantiert also keinen Anlageerfolg. Sowohl der jeweilige Investitionszeitpunkt als auch die ungleichmäßige Marktentwicklung generieren sehr unterschiedliche Renditen für ein fixes Investment – trotz gleicher Anlagedauer.

Dazu kommt: Aufgrund von wechselnden Marktphasen ist eine statische Asset Allokation selten optimal. Denn während sich die strategische Allokation eines diversifizierten Portfolios an langfristigen Erwartungen orientiert, ändert sich die aktuelle Situation an Finanzmärkten oft unvermittelt. Anlagerisiken steigen häufig schlagartig an mit der Folge, dass Renditeerwartungen illusorisch werden. Die Konsequenz: Eine aktive Steuerung der Asset Allokation ist notwendig, um Risiken im Zeitverlauf zu steuern. Mit quantitativen Methoden, modernen Algorithmen und künstlicher Intelligenz lassen sich Risiken und Wechselwirkungen zwischen Finanzmärkten synchron erfassen und finanzmathematisch abschätzen.

Große Unterschiede in der Fondsentwicklung durch den Einsatz von TOPAS

Risikomanagement-Modell muss frei sein von emotionalen Entscheidungen

Die Lösung dafür ist ein wissenschaftlich geprüfter, digitaler Prozess der Risikoüberwachung und Allokationssteuerung. Die Risikomessung dient als Grundlage, während die Identifikation struktureller Veränderungen das Ergebnis dieses Prozesses darstellt. Das Modell „TOPAS“ überwacht und steuert das im Vorfeld definierte Risiko-Ertrags-Profil eines Portfolios mit einem innovativen, durch das statistische Beratungslabor des Instituts für Statistik der Universität München evaluierten Optimierungsverfahren. Das Modell verbindet dabei eine Reihe quantitativer Verfahren, die wissenschaftliche Erkenntnisse renommierter Experten wie Robert F. Engle, John Y. Campbell, Fischer Black und Robert Litterman nutzen. Nach einer individuellen Allokationsberatung und Modellkalibrierung werden mit „TOPAS“ täglich dynamische Risikooptimierungen durchgeführt und gegebenenfalls Reallokationen übermittelt.

Auf diese Weise wird für das ausgewählte Titeluniversum eines Fonds oder eines Vermögensverwaltungsportfolios Tag für Tag die Allokation eines Portfolios balanciert, um den sich jeweils ändernden Marktbedingungen zu entsprechen. Ein solches Modell ist dabei frei von emotionalen Entscheidungen oder typischen Wahrnehmungsverzerrungen beim Versuch, Richtung oder Zeitdauer einer speziellen Marktbewegung zu prognostizieren. Wir zielen nicht auf die Performanceerhöhung ab, vielmehr liegt das Anlageziel in einer hochgradig effizienten Steuerung des Risiko-Rendite-Profils der Gesamtanlage. Auf diese Weise können die Faktorprämien von Wachstumswerten eingenommen werden, während die Volatilität auf einem gesamtmarktüblichen Niveau gehalten wird. Das macht Growth Investing dann auch unter schwierigen Marktbedingungen interessant.

Quelle: Prof. Dr. Patrick Peters

Für weitere Fragen stehe wir Ihnen wie immer gerne zur Verfügung.

Herzliche Grüße aus Stuttgart

Tilmann Speck

Christian Hintz

Gerd Schäfer