AI Leaders A: WKN A2P37J | AI Leaders C: WKN A2PF0M

AI Leaders A: WKN A2P37J

AI Leaders C: WKN A2PF0M

AI Leaders C: WKN A2PF0M

Midjourney prompted by THE DECODER

Wie geht die Welt zu Ende? Ein neues Paper gibt einen Überblick über katastrophale KI-Risiken.

Die rasante Entwicklung der künstlichen Intelligenz hat in den letzten Monaten zu wachsender Besorgnis in Forschung und Politik geführt. Mit Anhörungen im US-Senat, einem Brief, der einen Trainingsstopp fordert, und einer Art Welttournee von OpenAI-CEO Sam Altman hat die Debatte um die Ausrichtung und die möglichen Risiken von KI-Systemen im Jahr 2023 einen neuen Höhepunkt erreicht.

Das US-basierte Center for AI Safety (CAIS) bietet nun in einem Paper eine umfassende Übersicht alle „katastrophalen KI-Risiken“, also solche, die großflächig Schaden verrusachen können.

Die vier Kategorien katastrophaler KI-Risiken

Die Forschenden unterteilen die Risiken in vier Kategorien:

Für jede Risikokategorie beschreibt das Team spezifische Gefahren, präsentiert anschauliche Geschichten, stellt Idealszenarien vor und macht praktische Vorschläge, wie diese Gefahren gemindert werden können.

„Wenn wir uns proaktiv mit diesen Risiken auseinandersetzen, können wir die Vorteile der KI nutzen und gleichzeitig das Potenzial für katastrophale Folgen minimieren“, so das Team.

Den kompletten Überblick gibt es im Paper „An Overview of Catastrophic AI Risks“.

ZUSAMMENFASSUNG

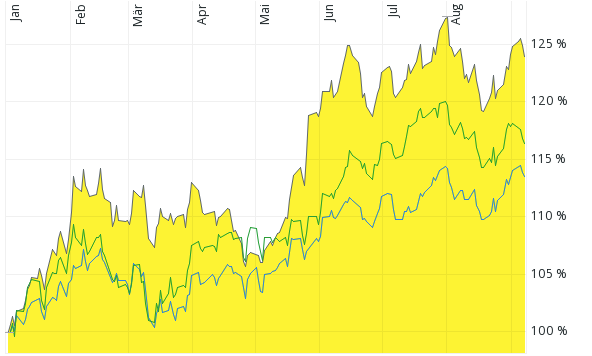

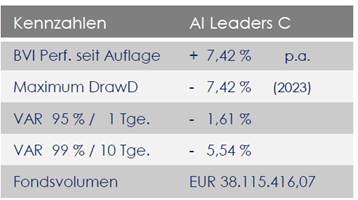

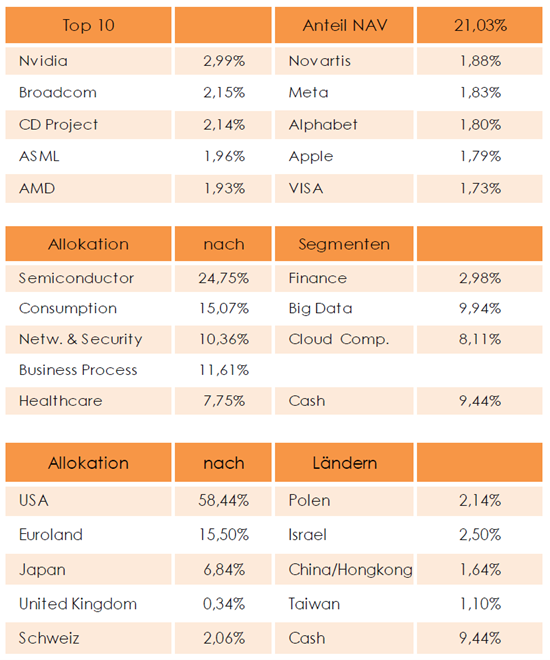

Der AI Leaders hat wie erwartet im August eine kleine Korrektur von -2,42% erwirtschaftet und liegt mit 24% seit Jahresbeginn komfortabel im Plus. In der ersten Hälfte des Augustes wurde das Portfolio zu Lasten Konsum und Halbleiter und zugunsten Kasse sowie Cloud Computing geringfügig umgeschichtet.

Auch im Vergleich zum MSCI World Index und dem S&P 500 konnte seit Jahresbeginn eine deutliche Outperformance erwirtschaftet werden, ohne dass wir dies mit einer erhöhten Volatilität verbunden gewesen ist.

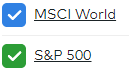

Im Vergleich zu seinen Mitbewerbern konnte sich der AI Leaders den letzten 12 Monaten deutlich von seiner Konkurrenz absetzen, was die folgende Grafik dokumentiert.

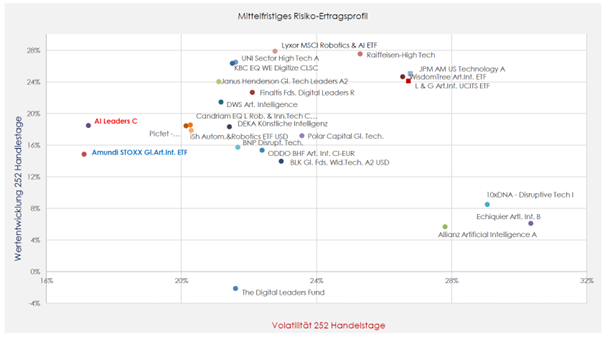

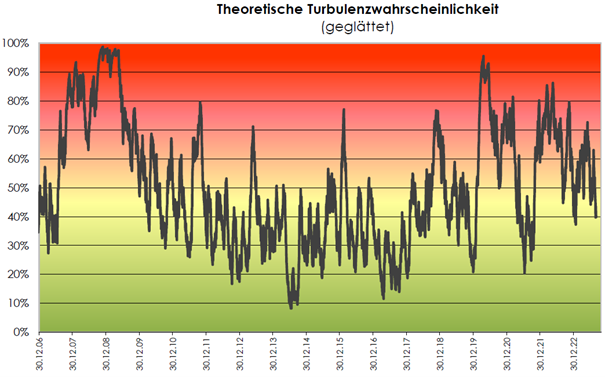

Der für den AI Leaders berechnete Turbulenzindex zeigt eine Beruhigung, was zu einer verstärkten strategischen Ausrichtung des Fonds führt.

Die weitere Entwicklung des AI Leaders sehen wir sehr positiv, da unsere Portfoliounternehmen eine zunehmenden Wachstumsschub erleben.

Für weitere Fragen stehe wir Ihnen wie immer gerne zur Verfügung.

Herzliche Grüße aus Stuttgart

Tilmann Speck

Christian Hintz

Gerd Schäfer

AI Leaders – We invest in future Technology

Lassen Sie sich den Megatrend KI nicht entgehen!