AKTUELLE NEWS AUS DER KI-WELT

AI LEADERS – Der Fonds

Sehr geehrte Investoren und Freunde, der AI-Leaders konnte in den letzten 12 Monaten einen Wertzuwachs von 33% erwirtschaften und liegt bei einem Fondsvolumen von 50 Mio. Euro.

| In den letzten 12 Monaten hat der AI-Leaders den S&P 500 (grün) deutlich outperformt: |

| Gleiches gilt auch für den MSCI World Index: |

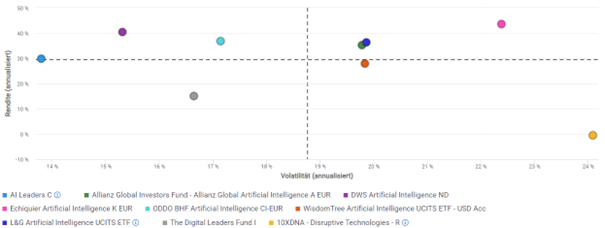

Gleichzeitig zeigt der AI-Leaders das beste Risiko-Rendite Verhältnis aller KI-Aktienfonds bei einer Volatilität von unter 14% auf.

Risiko-Rendite-Diagramm 12 Monate

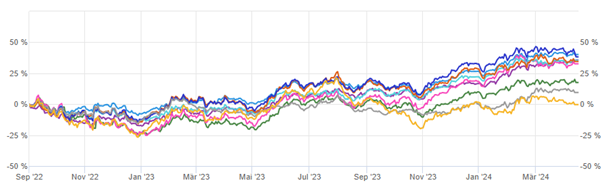

Seitdem wir (ab 1.9.2022) über TOPAS eine KI für das Risikomanagement einsetzen, liegt der Fonds mit einem Zuwachs von über 40% auch im Zeitverlauf an der Spitze seiner Vergleichsgruppe, gefolgt von L&G (mit deutlich höherer Volatilität).

Rendite im Zeitverlauf in % seit 1. September 2022

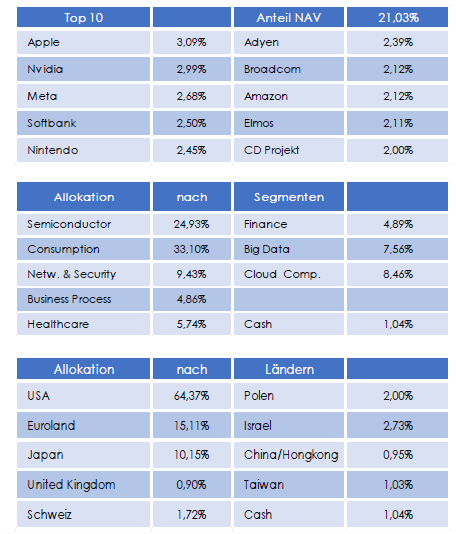

Bei den größten Werten (Top 10) hat es keine wesentlichen Veränderungen ergeben. Seit Anfang des Jahres wurde der Anteil von Cyber Security und Cloud Computing reduziert und in Aktien aus der zweiten und dritten Reihe verstärkt investiert. Healthcare wurde schon Ende 2022 untergewichtet, könnte aber von kommenden Zinssenkungen profitieren.

Bedingt durch das hohe Wachstum und Gewinnentwicklung unserer Aktien können wir über die nächsten Jahre mit einer sehr erfreulichen Entwicklung des AI-Leaders rechnen. Mit kurzfristigen Rücksetzern muss dabei immer gerechnet werden.

FINANZSEKTOR SETZT AUF GENERATIVE

KI UND ERWARTET BREITE ADAPTION IN

ZWEI JAHREN, ZEIGT STUDIE

Bild: Midjourney prompted by THE DECODER

Laut einer Studie des Alan Turing Institute wird die Finanzindustrie den Einsatz großer Sprachmodelle vorantreiben. Die Studie wurde in Zusammenarbeit mit HSBC, Accenture sowie der britischen Finanzaufsichtsbehörde FCA durchgeführt.

Die Finanzbranche, die in der Vergangenheit neue Technologien schnell adaptiert hat, hat laut den Autoren bereits damit begonnen, Sprachmodelle zur Unterstützung verschiedener interner Prozesse einzusetzen und aktiv potenzielle Einsatzmöglichkeiten für marktorientierte Aktivitäten in Beratung und Handel zu evaluieren. So ergab eine Umfrage von UK Finance, dass sich bereits 2023 mehr als 70 Prozent der teilnehmenden Finanzinstitute in der Proof-of-Concept-Phase für generative KI-Lösungen befinden.

Zudem gibt es bereits spezialisierte Modlele: Bloomberg hat beispielsweise mit BloombergGPT ein Modell mit 50 Milliarden Parametern entwickelt, das für eine Reihe von Finanzaufgaben wie Nachrichtenanalyse und Beantwortung von Fragen eingesetzt werden kann. In Tests wurde das Modell jedoch von GPT-4 geschlagen. FinGPT ist ein weiteres Beispiel für spezialisierte Finanz-Sprachmodelle.

Die Experten erwarten, dass Sprachmodelle innerhalb der nächsten zwei Jahre in externe Finanzdienstleistungen wie Investmentbanking und die Entwicklung von Risikokapitalstrategien integriert werden.

Experten erwarten breiten Einsatz generativer KI in der Finanzbranche

Neben einer Literaturstudie führten die Forscher einen Workshop mit 43 Experten aus großen Geschäfts- und Investmentbanken, Aufsichtsbehörden, Versicherungsunternehmen, Zahlungsdienstleistern, Behörden und Rechtsberufen durch.

Die Mehrheit der Workshop-Teilnehmer (52 %) nutzt Sprachmodelle bereits, um die Leistung bei informationsorientierten Aufgaben zu verbessern, von der Verwaltung von Sitzungsnotizen bis hin zu Einblicken in Cybersicherheit und Compliance. 29 % nutzen sie, um ihr kritisches Denken zu verbessern, und weitere 16 %, um komplexe Aufgaben zu zerlegen.

Der Sektor ist auch bereits dabei, Systeme einzuführen, die die Produktivität durch die schnelle Analyse großer Textmengen steigern, um Entscheidungsprozesse und Risikoprofile zu vereinfachen und die Investitionsforschung und Back-Office-Prozesse zu verbessern, so die Studie.

Auf die Frage nach der Zukunft von generativer KI im Finanzsektor antworteten die Teilnehmer, dass sie erwarten, dass die Systeme innerhalb der nächsten zwei Jahre in Dienstleistungen wie Investmentbanking und die Entwicklung von Risikokapitalstrategien integriert werden.

Sie hielten es auch für wahrscheinlich, dass Sprachmodelle integriert werden, um die Interaktion zwischen Mensch und Maschine zu verbessern, z.B. könnten Diktate und eingebettete KI-Assistenten die Komplexität wissensintensiver Aufgaben wie die Überprüfung von Vorschriften verringern.

Datenschutzbedenken stehen an erster Stelle

Die Studie weist aber auch auf Risiken hin. Datenschutzbedenken stehen an erster Stelle, da fast die Hälfte der Befragten Bedenken hinsichtlich der Risiken für die Privatsphäre äußerte, die mit Spracherkennungssystemen verbunden sind, insbesondere im Hinblick auf mögliche Datenlecks. Darüber hinaus wurden Bedenken hinsichtlich der Genauigkeit des generierten Textes und des Risikos von Automatisierungsfehlern geäußert, wobei die zunehmende Abhängigkeit von Sprachmodellen potenziell negative Auswirkungen auf das menschliche Urteilsvermögen und die menschliche Kontrolle haben könnte.

Die Studie schließt mit Empfehlungen zur Entwicklung branchenweiter Analysen von Sprachmodellbewertungen und zur Erforschung der Möglichkeiten von Open-Source-Modellen, um eine vertrauenswürdige und sichere Integration zu gewährleisten.

Die Mehrheit der Workshop-Teilnehmer (52 %) nutzt Sprachmodelle bereits, um die Leistung bei informationsorientierten Aufgaben zu verbessern, von der Verwaltung von Sitzungsnotizen bis hin zu Einblicken in Cybersicherheit und Compliance. 29 % nutzen sie, um ihr kritisches Denken zu verbessern, und weitere 16 %, um komplexe Aufgaben zu zerlegen.

Der Sektor ist auch bereits dabei, Systeme einzuführen, die die Produktivität durch die schnelle Analyse großer Textmengen steigern, um Entscheidungsprozesse und Risikoprofile zu vereinfachen und die Investitionsforschung und Back-Office-Prozesse zu verbessern, so die Studie.

Auf die Frage nach der Zukunft von generativer KI im Finanzsektor antworteten die Teilnehmer, dass sie erwarten, dass die Systeme innerhalb der nächsten zwei Jahre in Dienstleistungen wie Investmentbanking und die Entwicklung von Risikokapitalstrategien integriert werden.

Sie hielten es auch für wahrscheinlich, dass Sprachmodelle integriert werden, um die Interaktion zwischen Mensch und Maschine zu verbessern, z.B. könnten Diktate und eingebettete KI-Assistenten die Komplexität wissensintensiver Aufgaben wie die Überprüfung von Vorschriften verringern.

Zusammenfassung

- Laut einer Studie des Alan Turing Instituts könnten Large Language Models (LLMs) innerhalb von zwei Jahren den Finanzsektor revolutionieren, indem sie Betrug erkennen, Finanzinformationen generieren und Kundenservice automatisieren.

- Bereits 52% der befragten Finanzexperten nutzen LLMs zur Verbesserung der Leistung bei informationsorientierten Aufgaben, während 29% sie zur Steigerung des kritischen Denkvermögens und 16% zur Zerlegung komplexer Aufgaben einsetzen.

- Die Studie empfiehlt, dass Finanzdienstleister, Regulierungsbehörden und politische Entscheidungsträger sektorübergreifend zusammenarbeiten, um Wissen über die Implementierung und Nutzung von LLMs auszutauschen und zu entwickeln, insbesondere im Hinblick auf Sicherheitsbedenken.

GOOGLE DEEPMIND ENTWICKELT

SCHACH-KI AUF GROßMEISTERNIVEAU

MIT SPRACHMODELLARCHITEKTUR

Bild: Midjourney prompted by THE DECODER

Die neueste Schach-KI von Google DeepMind nutzt eine Sprachmodell-Architektur, spielt auf hohem Niveau und zeigt, dass Transformer wohl mehr sein können als stochastische Papageien.

Forscher von Google DeepMind haben ein KI-Modell entwickelt, das Schach auf Großmeisterniveau spielt, ohne auf die komplexen Suchalgorithmen zurückzugreifen, die bisher starke Schachprogramme wie Stockfish 16, IBMs Deep Blue oder auch Deepminds AlphaZero auszeichnen.

Stattdessen hat das DeepMind-Team ein 270 Millionen Parameter umfassendes Transformer-Modell mit Schachpartien trainiert. Herkömmliche Schachcomputer verwenden ausgeklügelte Algorithmen und Suchstrategien, um den besten Zug zu finden, während das DeepMind-Modell ausschließlich auf der Vorhersage von Zugbewertungen basiert.

Google Deepminds Transformer-Modell lernt von Stockfish

Zunächst sammelte das Team 10 Millionen Schachpartien und wies jedem Brett einen Wert zu, der die Gewinnwahrscheinlichkeit nach Stockfish 16 angibt. Dann berechneten sie alle legalen Züge für jede Partie und bewerteten sie ebenfalls, was zu einem großen Datensatz von 15 Milliarden Datenpunkten führte. Das Transformer-Netzwerk lernte dann, diese Spielwerte vorherzusagen, indem es mit diesem Datensatz durch überwachtes Lernen trainiert wurde. Das Netz wurde so optimiert, dass die vorhergesagten Werte den von Stockfish gelieferten Werten so nahe wie möglich kamen. Im Prinzip destillierte das Team so die Fähigkeiten von Stockfish in eine Schach-Policy für das Transformer-Modell.

In Tests erreichte das Modell in Blitzschachpartien gegen menschliche Spieler eine Elo-Zahl von 2895, liegt damit auf Großmeisterniveau und konnte eine Reihe anspruchsvoller Schachprobleme lösen. Damit übertrifft das Transformer-Netz auch AlphaZero, wenn dies ohne die MCTS-Suchstrategie (Monte Carlo Tree Search) eingesetzt wird.

Allerdings hat das Modell auch Einschränkungen, so kann es den Spielverlauf nicht speichern und nicht auf Basis der Spielhistorie planen. Außerdem spielt es gegen Schachcomputer schlechter als gegen Menschen, insbesondere in Situationen, in denen Menschen normalerweise aufgeben, während Schachcomputer das Spiel trotz geringer Chancen zu Ende spielen. Das Team ist jedoch der Ansicht, dass diese Probleme gelöst werden können.

Forscher von Google DeepMind haben ein KI-Modell entwickelt, das Schach auf Großmeisterniveau spielt, ohne auf die komplexen Suchalgorithmen zurückzugreifen, die bisher starke Schachprogramme wie Stockfish 16, IBMs Deep Blue oder auch Deepminds AlphaZero auszeichnen.

Stattdessen hat das DeepMind-Team ein 270 Millionen Parameter umfassendes Transformer-Modell mit Schachpartien trainiert. Herkömmliche Schachcomputer verwenden ausgeklügelte Algorithmen und Suchstrategien, um den besten Zug zu finden, während das DeepMind-Modell ausschließlich auf der Vorhersage von Zugbewertungen basiert.

Schachfähigkeiten als Argument gegen Papageien

Diese Forschung ist nicht nur für das Schachspiel von Bedeutung, sondern bietet auch Einblicke in das Potenzial der Transformer-Architektur in anderen Bereichen. Das Team bezieht sich explizit auf das Narrativ von großen Sprachmodellen als „stochastische Papageien“.

„Unsere Arbeit reiht sich damit in eine schnell wachsende Literatur ein, die zeigt, dass komplexe und anspruchsvolle Algorithmen in Feed-Forward-Transformatoren destilliert werden können. Dies impliziert einen Paradigmenwechsel, weg von der Betrachtung großer Transformatoren als ’nur‘ statistische Mustererkenner, hin zu einer Betrachtung als leistungsfähige Technik für die generelle Approximation von Algorithmen.“ |

Andere Projekte wie OthelloGPT haben bereits gezeigt, dass Transformer mehr als nur statistische Mustererkenner sein können. |

Zusammenfassung

- Google DeepMind hat eine KI entwickelt, die Schach auf Großmeisterniveau spielt, indem sie eine Transformer-Architektur verwendet, anstatt komplexe Suchalgorithmen wie Stockfish 16 oder AlphaZero.

- Das Team trainierte das 270 Millionen Parameter umfassende Transformer-Modell mit Schachpartien und verwendete überwachtes Lernen, um die von Stockfish gelieferten Werte vorherzusagen.

- Diese Forschung zeigt das Potenzial der Transformer-Architektur in anderen Bereichen und kann als Hinweis gesehen werden, dass große Sprachmodelle mehr als nur „stochastische Papageien“ sind.

Herzliche Grüße aus Stuttgart

Tilmann Speck

Christian Hintz

Gerd Schäfer